下一代AI硬件:模型盒与MCP插件的协同进化

一、技术核心:模型盒与MCP的定位

-

模型盒(Model Box)

- 定义:一种模块化AI硬件单元,通过封装计算资源、存储和通信接口,实现AI模型的快速部署与动态适配。

- 功能特点:

- 异构计算支持:兼容CPU、GPU、NPU等硬件,优化模型运行效率。

- 边缘端集成:低功耗设计,支持本地化推理与隐私保护。

- 类比:类似“乐高积木”,通过标准化接口灵活组合算力模块。

-

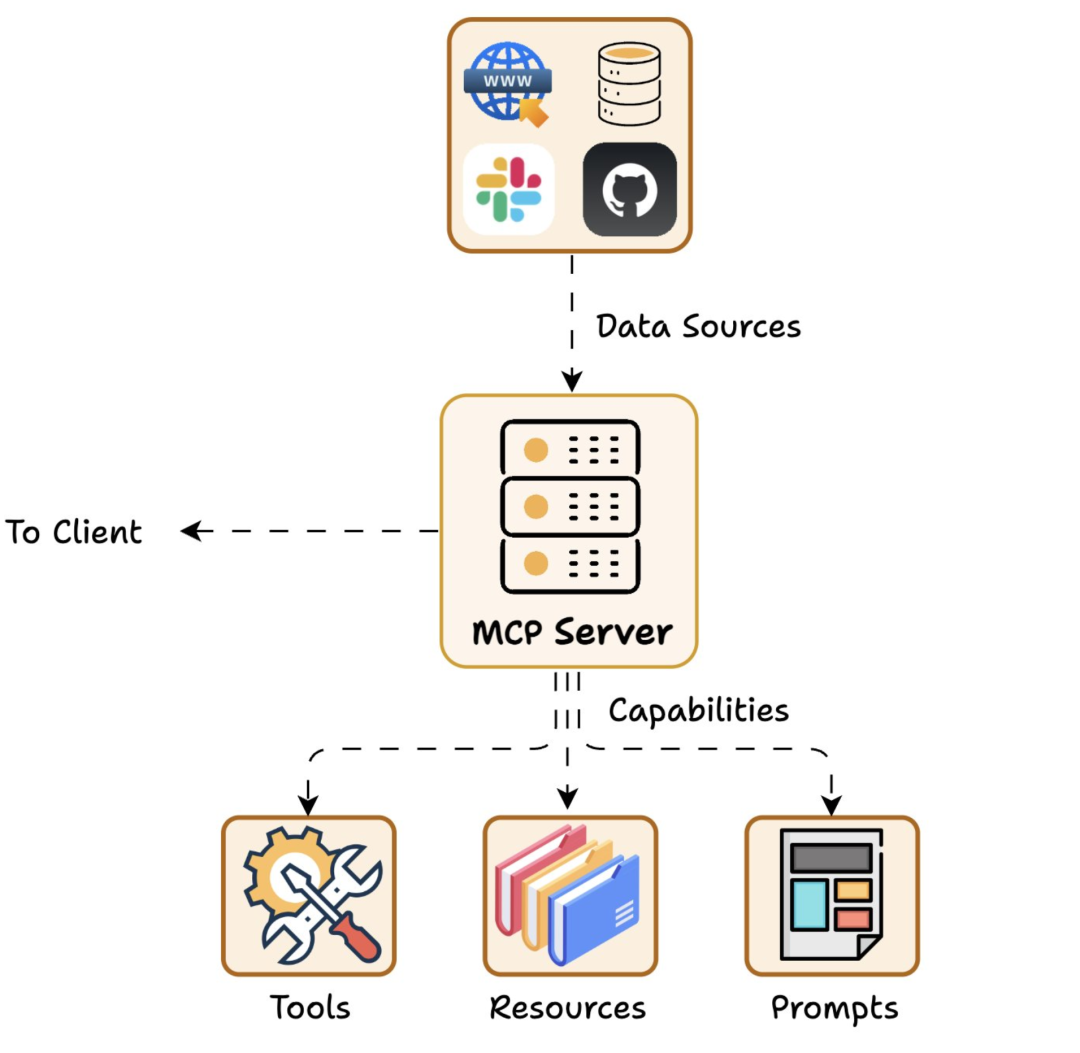

MCP插件(Model Context Protocol)

- 定义:基于MCP协议的中间件,连接AI模型与外部工具/硬件,实现动态资源调用与上下文管理。

- 功能特点:

- 工具动态发现:自动检索可用API或硬件设备(如传感器、机械臂)。

- 上下文感知:携带历史交互数据,提升任务连贯性(如连续对话中调用地图API)。

二、协同优势:1+1>2的技术突破

| 维度 | 传统AI硬件 | 模型盒+MCP |

|---|---|---|

| 开发效率 | 需针对不同硬件定制代码 | 通过MCP协议标准化接口,跨平台复用代码 |

| 实时性 | 静态数据连接,延迟高 | 动态数据流交互(如实时调用IoT传感器数据) |

| 硬件利用率 | 固定算力分配,资源浪费 | 模型盒按需调度算力(如突发任务启用备用NPU) |

| 隐私保护 | 依赖云端传输,风险高 | 模型盒本地计算+MCP本地工具调用(如医疗设备脱敏) |

三、应用场景:从实验室到产业落地

-

智能制造

- 模型盒部署于工业机器人,通过MCP调用质检摄像头和机械臂控制协议,实现瑕疵检测-修复闭环。

- 案例:某汽车工厂将缺陷识别速度提升40%,误判率降低15%。

-

智慧医疗

- 模型盒运行本地化诊断模型,MCP集成医疗设备API(如MRI影像数据),避免患者隐私外泄。

- 自动驾驶

- 车端模型盒处理实时路况,MCP动态调用高精地图更新与V2X通信模块,应对突发路障。

四、未来趋势:生态重构与挑战

-

硬件协议统一化

- MCP或成为类似“USB标准”的通用协议,推动硬件厂商开放接口规范。

- 潜在问题:不同厂商的协议兼容性可能引发市场割据。

-

开发范式革新

- 开发者从“写代码”转向“配置工具链”,通过MCP声明式调用资源。

-

边缘计算爆发

- 模型盒推动边缘节点智能化,预计2028年全球边缘AI芯片市场达$120亿。

五、总结:AI硬件的“安卓时刻”

模型盒与MCP插件的结合,正在打破传统AI硬件的“烟囱式”架构。这种模块化、协议驱动的模式,或将催生类似移动互联网的生态爆发——硬件厂商聚焦性能优化,开发者专注场景创新,最终推动AI从“技术能力”向“普适服务”跃迁。