研究核心结果

模型评估与威胁研究机构(Model Evaluation & Threat Research,METR)最新研究显示,资深开源开发者在使用生成式AI工具时的工作效率出现意外下降。具体研究数据表明,开发者在使用克劳德3.5/3.7(Claude 3.5/3.7 Sonnet)和游标专业版(Cursor Pro)等AI系统时,任务完成时间增加了19%。

实验设计与结果

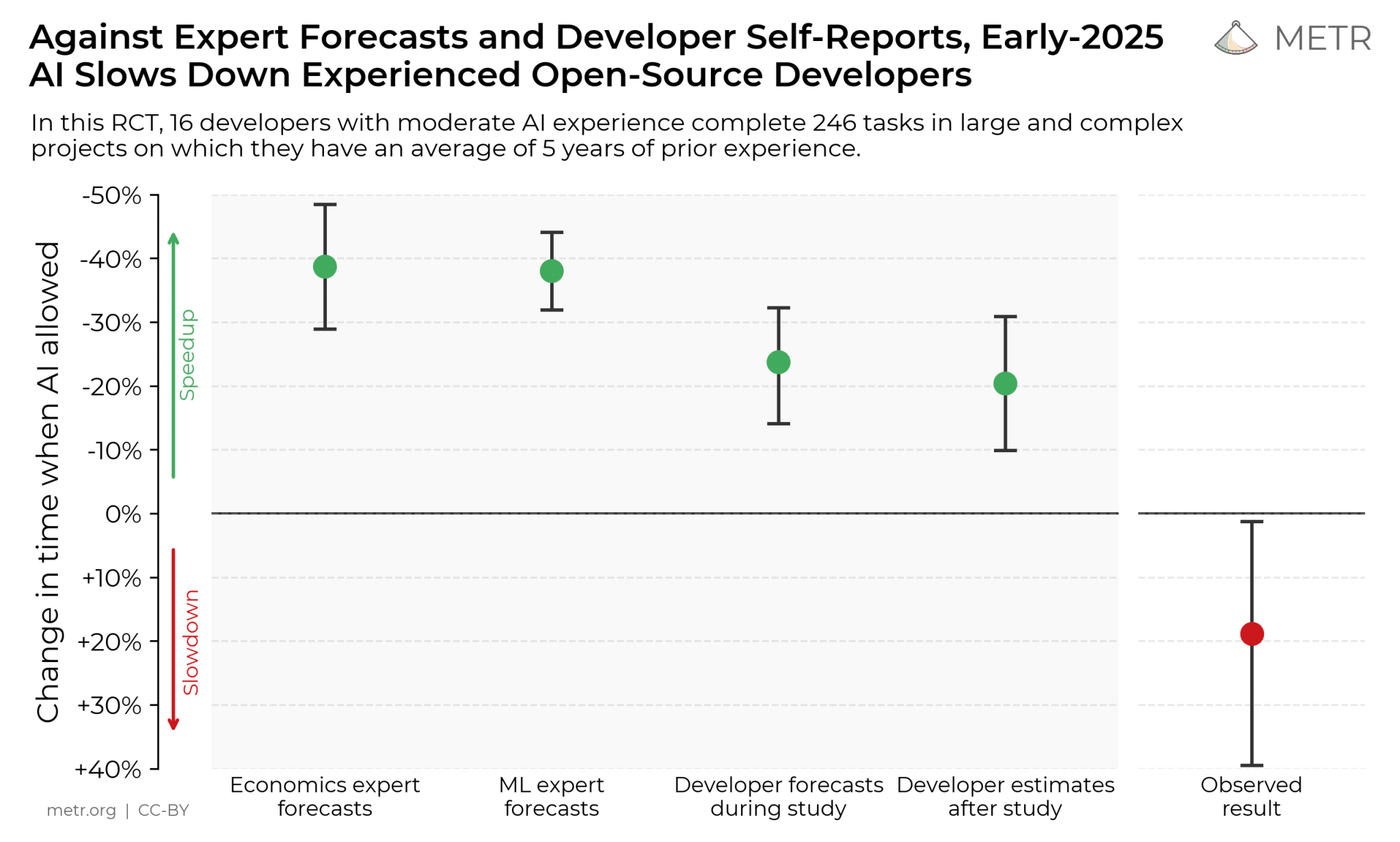

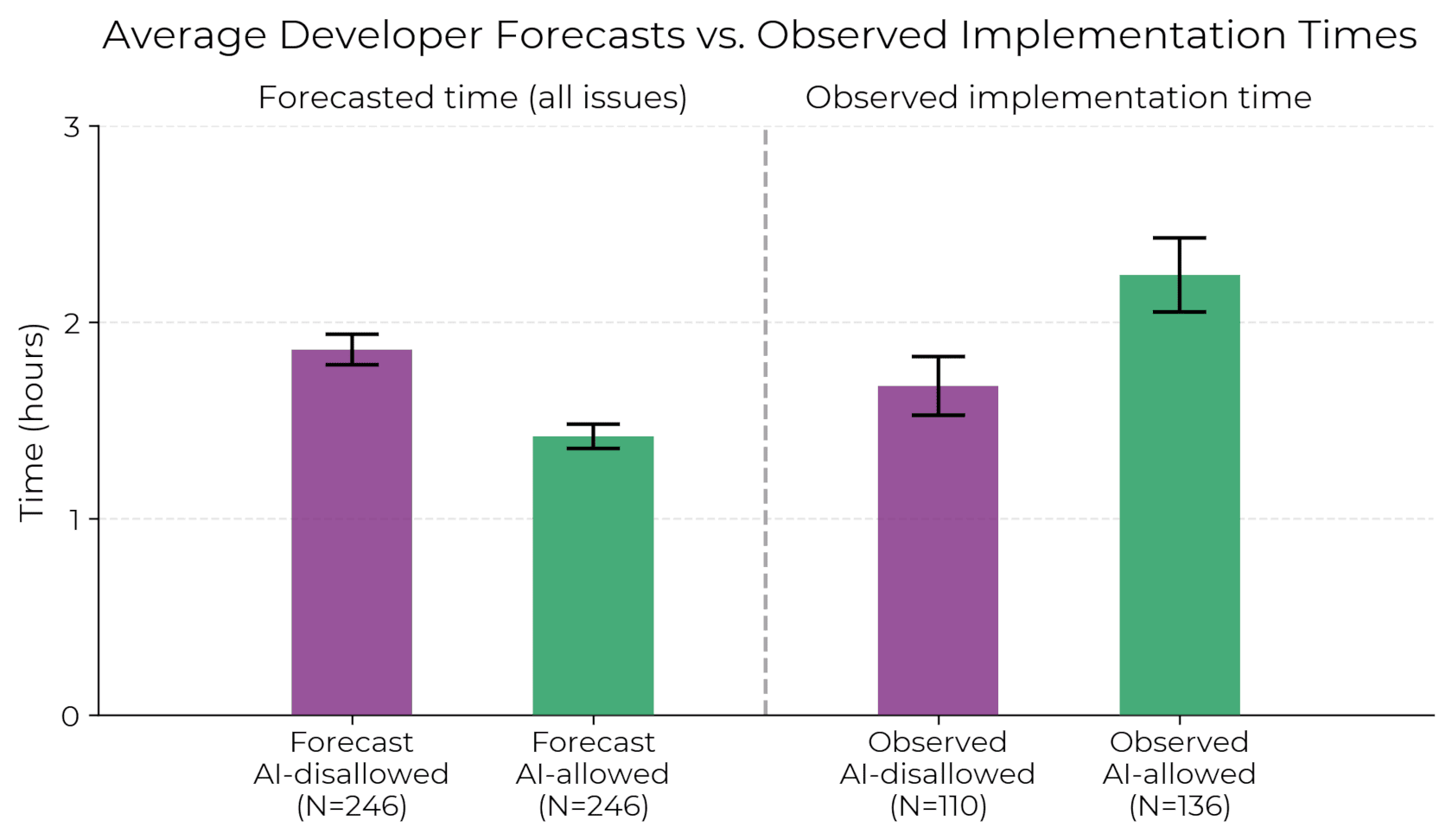

这项随机对照试验共有16名资深开源贡献者参与,完成了246个真实项目任务测试。参与者平均拥有5年相关代码仓库的开发经验。研究显示,尽管开发者最初预期AI辅助能提升24%的效率,并主观感知到20%的提升,但实际数据显示使用AI反而降低了工作效率。

预期与现实差距分析

研究发现AI实际生产力提升与感知之间存在显著差距。经济学和机器学习领域专家此前预测效率将提升38%-39%,这些预测被证明过于乐观。METR团队通过分析143小时的屏幕录像,发现效率下降主要源于三个方面:

- AI输出可靠性不足

- 难以适应复杂代码库

- 无法有效利用代码仓库上下文

研究启示与建议

研究数据显示,开发者将更多时间用于审查AI建议和等待生成结果,而非直接编写代码。虽然93%的参与者具备大语言模型使用经验,但仅44%使用过游标专业版(Cursor Pro)。即便是经验丰富的用户也出现效率下降的情况。

METR特别指出,这些研究结果不应过度推广。AI工具在其他场景中仍可能发挥作用,特别是对新手开发者或全新项目而言。然而,这些发现确实挑战了"最先进AI工具必然提升资深工程师效率"的普遍认知。

研究报告强调了在实际工作环境中谨慎评估AI工具的重要性,并建议不要仅依赖基准测试或个别成功案例来判断AI工具的实际效果。