研究发现

Essential AI公司发布了一项名为《重新思考预训练中的反思能力》(Rethinking Reflection in Pre-Training)的研究。该公司由《Attention Is All You Need》论文的共同作者阿希什·瓦斯瓦尼(Ashish Vaswani)创立。

核心发现

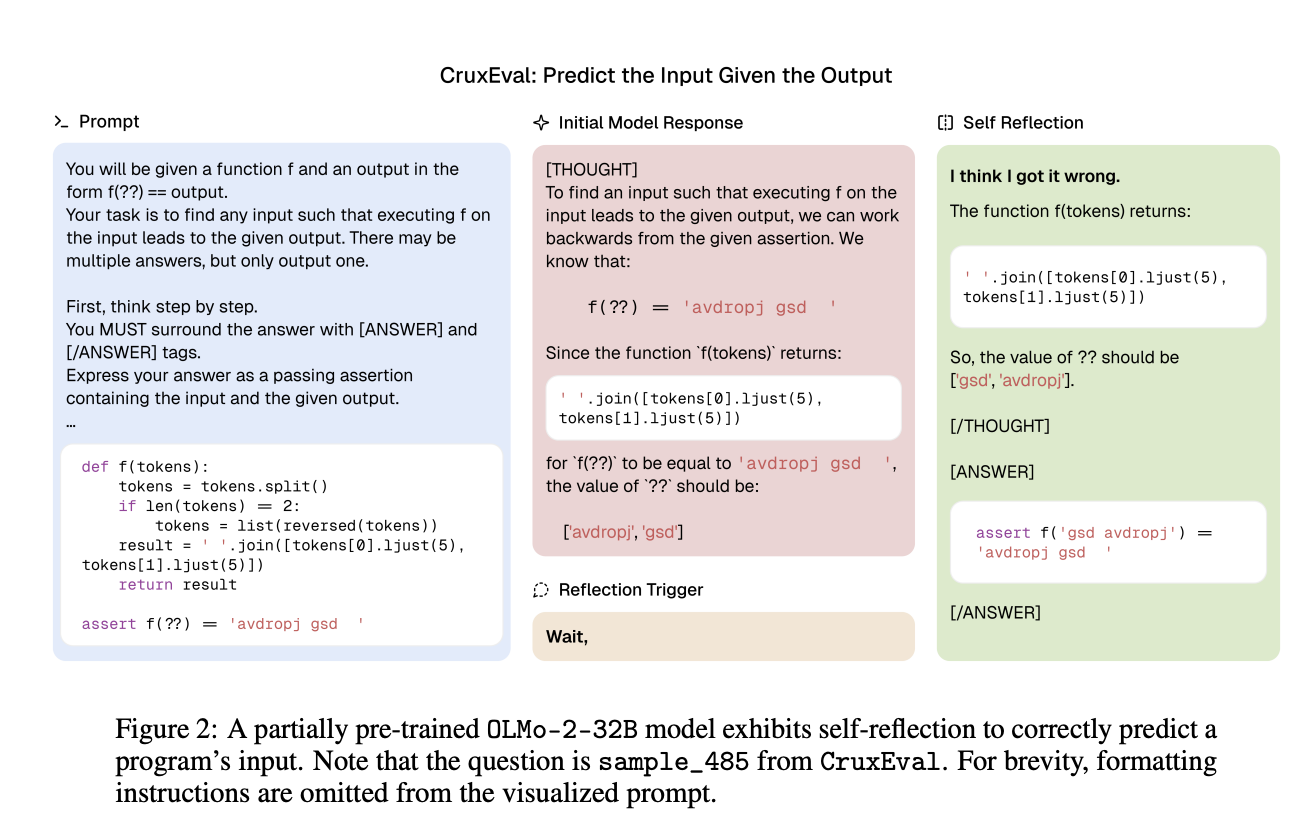

研究发现AI模型的自我反思能力在预训练阶段就已经形成。这与普遍认为需要通过微调或强化学习获得的观点不同。研究团队通过在训练不同阶段测试AI模型(OLMo-2),证实了反思能力是在训练过程中自然形成的。

研究方法

研究团队构建了包含数学、编程、逻辑推理和知识获取等领域的数据集。这些数据集中包含了经过刻意修改的思维链(Chain-of-Thought)推理路径,引入了算术错误和逻辑不一致等问题。研究发现,使用简单的自然语言触发器就能激活模型的反思能力。

研究结果

实验表明,即使是部分训练的模型在遇到"等等"这样的插入语时,也能够暂停、识别并纠正推理中的错误。在4万亿个标记上预训练的OLMo-2 7B模型在六个自我反思任务中展现出了自我纠正能力。随着训练的深入,模型识别错误和纠正推理的能力稳步提升。

公司背景

Essential AI于2023年12月结束隐形状态,获得了由谷歌(Google)、Thrive Capital、AMD等领投的5650万美元融资。公司致力于开发"全栈AI产品",包括提高重复性工作流程效率的大语言模型。值得注意的是,论文另一位共同作者妮基·帕尔马尔(Niki Parmar)最近已加入AI公司Anthropic。

《Attention Is All You Need》是谷歌于2017年发表的重要论文,介绍了Transformer架构,这一架构现已成为当今几乎所有大语言模型的基础。