系统概况

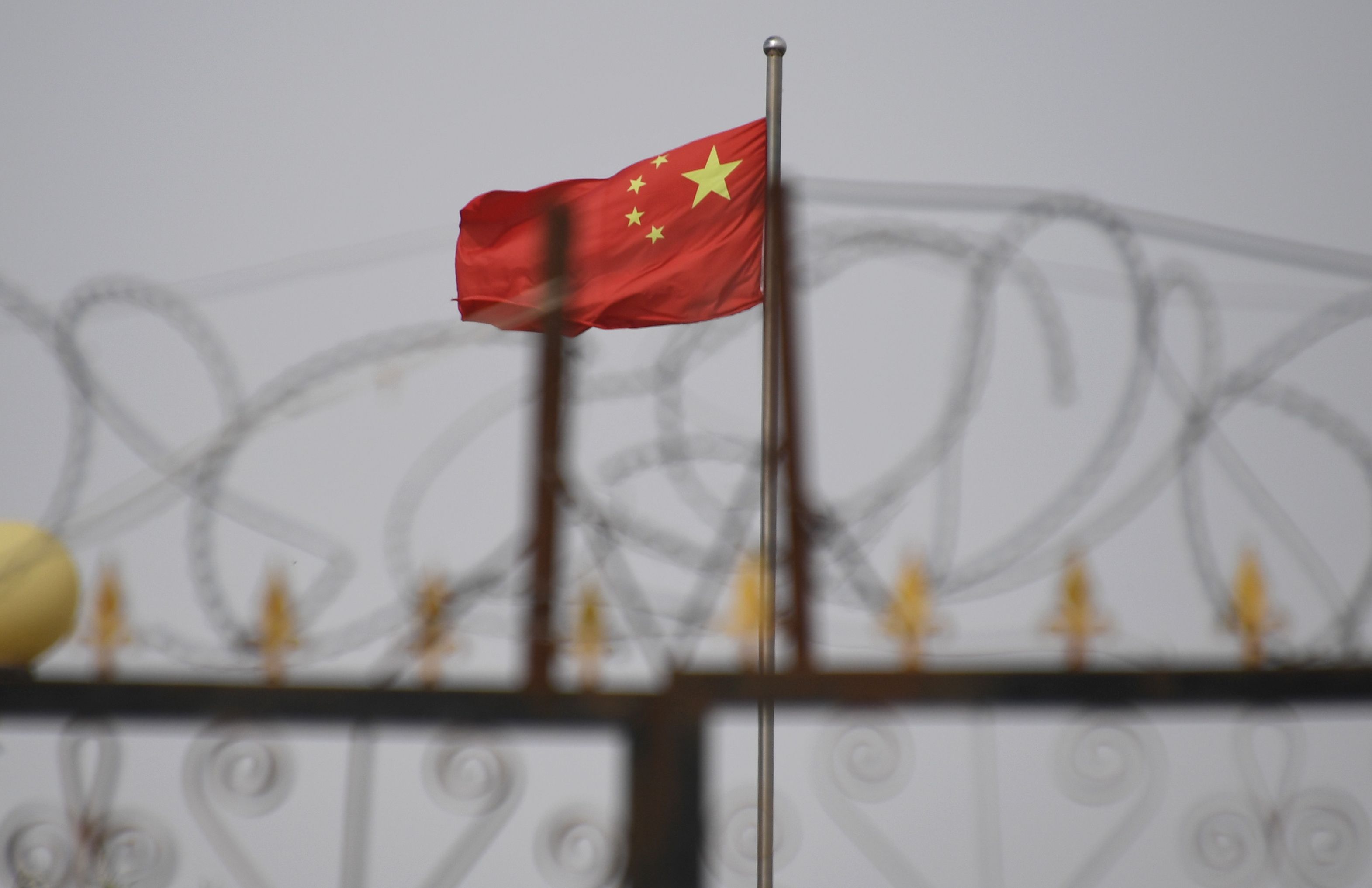

一条关于中国农村贫困的投诉、一篇报道党员腐败的新闻、一则关于警察勒索企业家的求助信息——这些仅是13.3万个用于训练大语言模型进行内容审查的样本中的几例。

据TechCrunch获得的一份泄露数据库显示,这套人工智能系统显著增强了现有的审查能力,其覆盖范围远超传统的敏感话题。该系统主要用于审查中国网民的在线言论,同时可能被用于提升人工智能模型的审查能力。

专家评估

加州大学伯克利分校研究员肖强(Xiao Qiang)在检查该数据集后指出,这是中国政府或其附属机构计划利用大语言模型(LLM)加强管控的明确证据。他强调,这种基于人工智能的审查机制将显著提高信息管控的效率和精确度。

数据库发现与分析

安全研究员NetAskari在百度服务器的一个未加密Elasticsearch数据库中发现了这些数据。数据显示内容更新至2024年12月,系统采用类似ChatGPT的方式,要求大语言模型识别涉及政治、社会生活和军事等敏感话题的内容。

重点审查内容

系统重点关注可能引发社会动荡的话题,包括:

- 污染和食品安全丑闻

- 金融欺诈和劳资纠纷

- 涉台和军事相关信息

- 政治讽刺内容

数据库中"台湾"一词出现超过15,000次,显示对涉台内容的高度关注。系统还特别关注可能引发群体性事件的内容,如企业主投诉警察勒索、农村贫困状况等社会问题。

技术发展趋势

传统审查方法主要依赖关键词过滤,而新一代人工智能技术能够识别更细微的批评内容。通过持续学习,这些系统的审查能力将不断提升。伯克利研究员肖强指出,在中国人工智能模型如DeepSeek快速发展的背景下,人工智能驱动的内容管控正变得更加精密。